Come costruire un AI Agent con n8n: guida pratica per PMI (2026)

Come si costruisce un AI Agent reale con n8n? In questa guida mostro tre livelli di complessità con workflow reali già in produzione: dal bot Telegram con filtro spam (Livello 0) all'agente di lead enrichment B2B che cerca profili LinkedIn con Apify e aggiorna Salesforce in automatico (Livello 1). Con metriche reali, system prompt, stack tecnico e consigli su dove iniziare se sei una PMI.

TL;DR

Un AI Agent in n8n è un workflow con un LLM al centro che può prendere decisioni e agire su sistemi esterni. Esistono tre livelli per le PMI: bot semplice senza tool use (Livello 0, 4–8 ore di setup), agente con tool use su dati reali (Livello 1, 16–40 ore) e agente RAG su knowledge base aziendale (Livello 2). In questa guida mostro i Livelli 0 e 1 con workflow reali in produzione, metriche concrete e stack tecnico completo.

Cos'è un AI Agent in n8n

Un AI Agent in n8n è un nodo workflow che integra un Large Language Model come motore decisionale, dotandolo di tool per interagire con sistemi esterni — database, CRM, API, canali di comunicazione. A differenza di un chatbot tradizionale, l'agente non risponde solo a messaggi: valuta il contesto, sceglie quale azione eseguire tra quelle disponibili e agisce autonomamente. In n8n il nodo si chiama "AI Agent" ed è disponibile nativamente dalla versione 1.x, con porte dedicate per Chat Model, Memory e Tool.

Prerequisito: se stai ancora valutando quale processo automatizzare nella tua PMI prima di scegliere la tecnologia, leggi prima la guida sull'automazione AI per le PMI italiane. Questa guida presuppone che tu abbia già identificato il caso d'uso.

Bot vs AI Agent: la distinzione che cambia tutto

Prima di scegliere l'architettura da costruire, è fondamentale capire la differenza tra un bot semplice con LLM e un AI Agent vero e proprio. La confusione tra i due è una delle cause principali di over-engineering (o under-engineering) nei progetti AI delle PMI.

| Caratteristica | Bot semplice (Livello 0) | AI Agent (Livello 1+) |

|---|---|---|

| Risponde a messaggi | ✅ | ✅ |

| Segue un flusso fisso | ✅ | ❌ (ragiona sul contesto) |

| Prende decisioni autonome | ❌ | ✅ |

| Usa tool/API esterni | ❌ | ✅ |

| Memory tra sessioni | Limitata (Simple Memory) | ✅ (Simple Memory, Redis, Postgres) |

| Agisce su CRM o database | ❌ | ✅ |

| Complessità setup n8n | Bassa (4–8 ore) | Media–Alta (16–120 ore) |

| Costo API LLM tipico | 10–30€/mese | 30–150€/mese |

La scelta dipende dal problema da risolvere, non dalla tecnologia più avanzata disponibile.

I tre livelli di complessità degli AI Agent in n8n

Per le PMI italiane ho identificato tre livelli di progressione che bilanciano risultati ottenibili e sforzo di implementazione.

| Livello | Architettura n8n | Caso d'uso tipico | Setup stimato |

|---|---|---|---|

| 0 — Bot semplice | Trigger → Filter → AI Agent (no tool) → Output | Assistente Telegram/WhatsApp, risposta FAQ | 4–8 ore |

| 1 — Agent con tool use | Trigger → Multi-source search → AI Agent (con tool) → Azione CRM | Lead enrichment, supporto con knowledge base strutturata | 16–40 ore |

| 2 — RAG | Trigger → Vector retrieval → AI Agent → Output | FAQ da documenti aziendali, assistente su specifiche tecniche | 40–120 ore |

Regola pratica: inizia sempre dal livello più basso che risolve il tuo problema. La complessità aggiuntiva porta valore solo se il problema la richiede esplicitamente.

Livello 0 — Il bot semplice: Claira su Telegram

Cosa ottieni

Un assistente AI che risponde autonomamente ai messaggi su Telegram 24/7, filtra automaticamente spam e richieste non pertinenti, e converte circa 1 conversazione su 10 in un appuntamento reale. Zero intervento umano per i messaggi di routine. Tempo di setup: una settimana lavorativa.

Come funziona

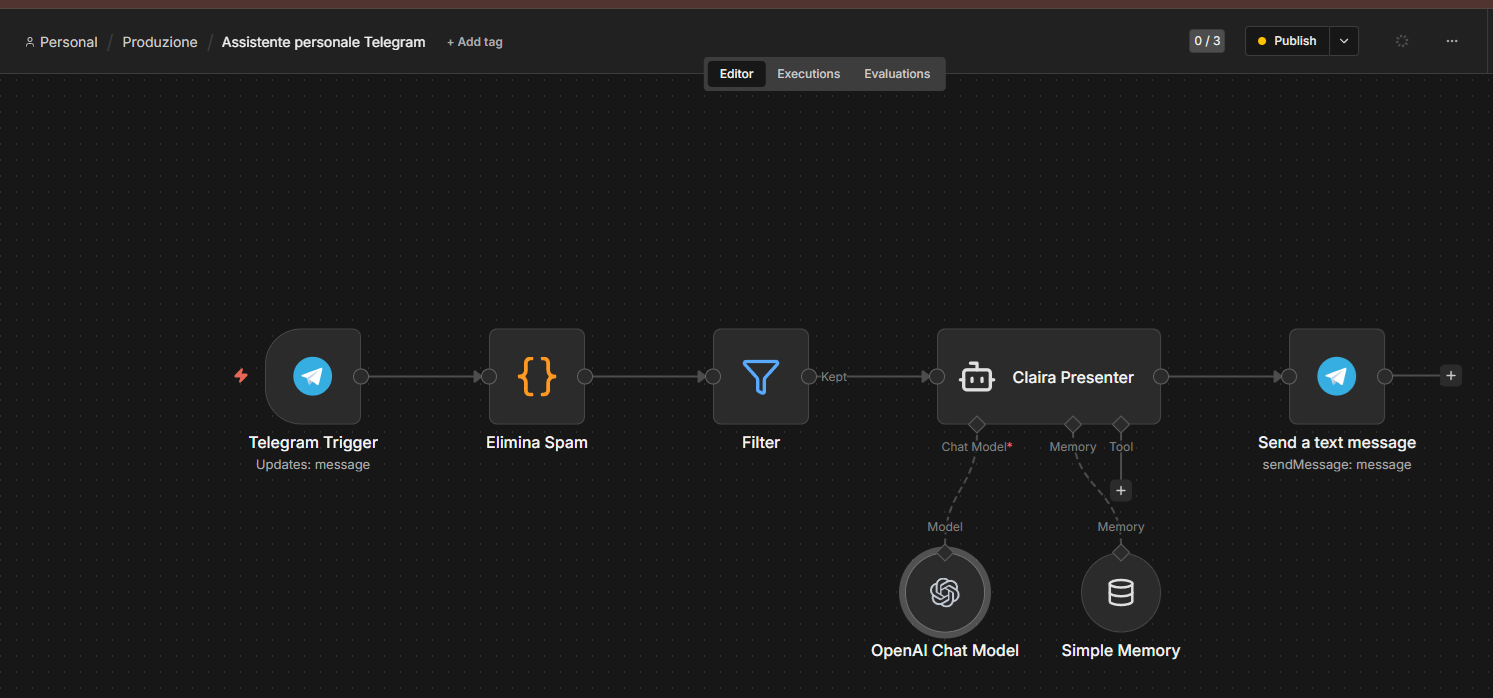

Claira è il bot Telegram personale che uso in produzione per gestire le prime interazioni commerciali. Il workflow in n8n segue questa architettura a cinque nodi:

Flusso nodi (da sinistra a destra):

-

Telegram Trigger — ascolta i nuovi messaggi in arrivo (

Updates: message). Ogni aggiornamento include il testo, l'ID mittente, il tipo di chat e i metadati Telegram. -

Elimina Spam (Code node JS) — estrae i dati strutturati dal payload Telegram e valuta i criteri spam. Produce un campo

_isSpambooleano che il nodo successivo usa per instradare il flusso. -

Filter — nodo nativo n8n. Condizione:

_isSpam = false→ percorsoKeptverso l'agente. I messaggi spam vengono scartati silenziosamente (nessuna risposta = nessun engagement con lo spammer). -

Claira Presenter (AI Agent) — il nodo centrale. Ha due sotto-nodi collegati:

- OpenAI Chat Model — il LLM (GPT-4o) che genera le risposte

- Simple Memory — mantiene il contesto della conversazione tra messaggi successivi dello stesso utente

- Nessun tool collegato: questo è Livello 0, l'agente lavora solo con system prompt e memory

-

Send a text message (Telegram) — invia la risposta al mittente tramite

sendMessage.

Nota tecnica: il Livello 0 non usa tool use. L'agente lavora esclusivamente con le informazioni nel system prompt e nella conversazione storica. Questo lo rende rapido da costruire, stabile in produzione e prevedibile nel comportamento.

Il filtro spam: codice del nodo "Elimina Spam"

Il Code node estrae i metadati dal payload Telegram e produce i flag necessari al nodo Filter a valle. I criteri spam sono completamente personalizzabili: puoi aggiungere keyword, bloccare utenti anonimi, o applicare regole basate sul tipo di messaggio.

// n8n Code Node — Elimina Spam

// Estrae il messaggio Telegram e valuta i criteri spam personalizzati

const update = $input.first().json;

const text = (update.message?.text || '').toLowerCase().trim();

const from = update.message?.from;

// Criteri spam — personalizza in base al tuo caso d'uso

const spamSignals = {

containsSpamKeywords: ['guadagna', 'click qui', 'offerta esclusiva', 'wh4tsapp'].some(

k => text.includes(k)

),

isTooShort: text.length < 3,

isAnonymous: !from?.username && !from?.first_name,

};

const isSpam = Object.values(spamSignals).some(Boolean);

return [{

json: {

...update,

_isSpam: isSpam,

_spamReasons: Object.entries(spamSignals)

.filter(([, v]) => v)

.map(([k]) => k),

},

}];Il nodo Filter a valle usa la condizione _isSpam = false per instradare solo i messaggi legittimi verso Claira.

Risultati reali in produzione

| Metrica | Valore |

|---|---|

| Messaggi spam filtrati dal sistema | 95% |

| Tasso di conversione in appuntamento | 1 su 10 conversazioni |

| Intervento umano per messaggi di routine | 0 |

| Costo API LLM stimato (caso azienda consulenza) | ~5–15€/mese |

Livello 1 — Agent con tool use: lead enrichment B2B

Cosa ottieni (per il CEO)

Ogni nuovo lead inserito in Salesforce viene arricchito automaticamente: l'agente cerca il profilo LinkedIn del contatto (prima via Google, poi scraping diretto), estrae le informazioni sull'azienda e genera un Ice Breaker personalizzato — un aggancio su misura per la prima email o chiamata — abbinando il lead al servizio del tuo catalogo più pertinente. Il record Salesforce viene aggiornato automaticamente, senza intervento umano.

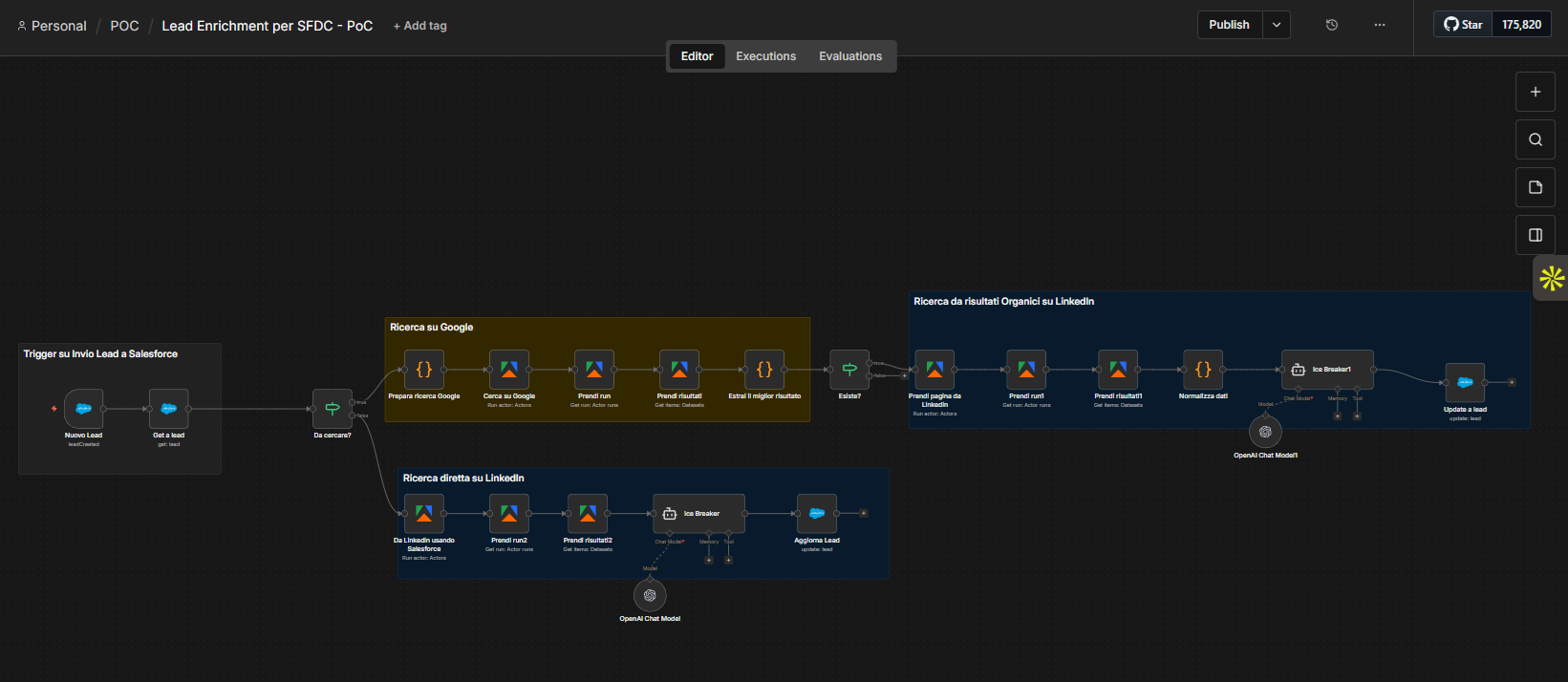

Come funziona (per il tecnico)

Questo è il salto di complessità rispetto al Livello 0: l'agente non risponde a messaggi ma reagisce a un evento aziendale (nuovo lead nel CRM) ed esegue una sequenza di ricerche multi-source prima di prendere una decisione e agire.

Stack tecnico:

- Trigger: Salesforce webhook (

leadCreated) - Google Search: Apify Actor (Google Search) — cerca

{nome} {azienda} site:linkedin.com - LinkedIn Scraping: Apify Actor (LinkedIn Profile Scraper) — estrae dati pubblici dal profilo trovato

- AI Agent: GPT-4o con system prompt dedicato per l'Ice Breaker

- Output: aggiornamento record Lead in Salesforce con Ice Breaker e servizio consigliato

Dettaglio tecnico chiave — il pattern Apify asincrono:

Ogni chiamata Apify richiede tre nodi distinti in n8n perché gli Actor sono asincroni:

- Run action: Actors — avvia l'Actor (ritorna subito con un

runId) - Get run: Actor runs — polling fino al completamento (n8n attende la risposta)

- Get items: Datasets — recupera i risultati dal dataset dell'Actor

Questo spiega perché nel workflow vedi tre blocchi Apify per ogni fase di ricerca (Google e LinkedIn).

Flusso decision completo:

Nuovo Lead (SFDC)

↓

Get a lead (SFDC)

↓

Da cercare? [filtro su presenza URL LinkedIn nel record]

│

├── [URL LinkedIn assente] → PATH 1: Ricerca su Google

│ ↓

│ Prepara ricerca Google (Code node — costruisce la query)

│ ↓

│ Cerca su Google (Apify Actor) → Prendi run → Prendi risultati

│ ↓

│ Estrai il miglior risultato (Code node — parsing JSON Apify)

│ ↓

│ Esiste URL LinkedIn? [filtro]

│ ↓ (sì)

│ Prendi pagina da LinkedIn (Apify Actor) → Prendi run1 → Prendi risultati1

│ ↓

│ Normalizza dati (Code node — standardizza output Apify)

│ ↓

│ Ice Breaker1 (AI Agent + OpenAI)

│ ↓

│ Update a lead (SFDC)

│

└── [URL LinkedIn presente in SFDC] → PATH 2: Ricerca diretta LinkedIn

↓

Da LinkedIn usando Salesforce (Apify Actor con URL dal CRM)

→ Prendi run2 → Prendi risultati2

↓

Ice Breaker (AI Agent + OpenAI separato)

↓

Aggiorna Lead (SFDC)Nota: i due Ice Breaker (Path 1 e Path 2) sono agenti separati — questo è intenzionale. Permettono di ottimizzare il system prompt in modo indipendente per i due contesti (dati arricchiti da Google+LinkedIn vs dati solo da LinkedIn diretto).

Il system prompt dell'Ice Breaker

Il system prompt è il cuore dell'agente. La struttura che uso:

Sei un assistente commerciale AI di Castaldo Solutions.

Ricevi dati aggiornati su un lead B2B e devi:

1. Identificare il servizio del catalogo più pertinente per quel lead

2. Scrivere un Ice Breaker personalizzato (max 2 righe, tono professionale e diretto)

3. Spiegare brevemente il perché della scelta

INPUT DISPONIBILE:

- Nome e ruolo: {{$json.firstName}} {{$json.lastName}}, {{$json.title}}

- Azienda: {{$json.company}}, settore {{$json.industry}}

- Sintesi profilo LinkedIn: {{$json.linkedinSummary}}

CATALOGO SERVIZI:

{{$json.servicesCatalog}}

OUTPUT RICHIESTO (solo JSON valido, nessun testo fuori dal JSON):

{

"bestService": "nome esatto del servizio dal catalogo",

"iceBreaker": "testo pronto per email o apertura chiamata",

"rationale": "perché questo servizio per questo lead specifico"

}

Regole: non inventare dati non presenti nell'input. Se il profilo è incompleto,

segnalalo nel campo rationale e proponi comunque il servizio più probabile.La variabile più importante è

servicesCatalog. Più è descrittivo e specifico il catalogo fornito in input, più l'Ice Breaker è preciso e contestuale. Un catalogo generico produce Ice Breaker generici. Questo è il punto di calibrazione con il ROI più alto.

Risultati reali in produzione

| Metrica | Valore |

|---|---|

| Lead B2B con profilo LinkedIn trovato | 85% (entro i 2 path di ricerca) |

| Ice Breaker contestualmente efficace | ~100% con catalogo servizi ben configurato |

| Lead richiedono intervento manuale | 15% (non trovati su LinkedIn) |

| Tempo per lead arricchito | ~90 secondi (vs 20–30 minuti manuale) |

Livello 2 — RAG e fine tuning: il passo successivo

Oltre i livelli 0 e 1 esiste un terzo livello di complessità: il Retrieval-Augmented Generation (RAG). In questo scenario l'agente non lavora solo con dati strutturati (messaggi, record CRM) ma interroga una knowledge base vettoriale — documenti aziendali, specifiche tecniche, contratti, manuali — per rispondere a domande complesse o generare output aderenti al contesto aziendale.

n8n supporta nativamente l'integrazione con Pinecone, Qdrant, Supabase pgvector e altri vector store. Il setup richiede però un'infrastruttura più elaborata: chunking dei documenti, generazione degli embedding, gestione degli aggiornamenti della knowledge base. L'investimento iniziale è di 40–120 ore.

Il fine tuning — addestrare un modello su dati aziendali proprietari — è uno step ancora più avanzato, fuori scope per la maggior parte delle PMI italiane nel 2026 per costi e complessità.

Dedicherò un articolo separato al RAG con n8n. Se vuoi essere avvisato, contattami.

Come scegliere il livello giusto per la tua PMI

| Se il tuo obiettivo è... | Parti dal Livello |

|---|---|

| Rispondere a messaggi Telegram o WhatsApp con AI | 0 |

| Filtrare richieste, gestire FAQ, pre-qualificare lead via chat | 0 |

| Arricchire automaticamente i dati nel CRM | 1 |

| Generare contenuti personalizzati da dati strutturati | 1 |

| Automatizzare ricerche multi-source e decisioni basate su risultati | 1 |

| Creare un assistente che risponde su documenti aziendali | 2 |

| Automatizzare analisi di contratti o specifiche tecniche | 2 |

Il Livello 0 è la pietra miliare zero: un'automazione funzionante in pochi giorni che dà valore immediato e allena il team all'uso degli agenti AI. Il Livello 1 è il primo passo verso l'automazione di un processo aziendale strutturato. Il Livello 2 è giustificato solo quando il volume e la varietà dei dati non strutturati rendono il RAG necessario, non opzionale.

Se non sei sicuro quale livello è adatto alla tua situazione, è esattamente il tipo di analisi che facciamo in una call di consulenza. Scopri i nostri servizi AI →

Come costruire il tuo primo AI Agent in n8n: 5 passi

Passo 1 — Scegli il trigger

Ogni agente parte da un evento. I trigger più comuni in n8n per le PMI:

- Telegram Trigger / WhatsApp — per bot conversazionali (Livello 0)

- Salesforce Trigger / HubSpot — per automazioni CRM-driven (Livello 1)

- Webhook — per integrazioni con qualsiasi sistema che supporti HTTP

- Schedule Trigger — per task periodici (batch enrichment, reportistica)

Il trigger determina quali dati sono disponibili nel nodo $input — e quindi cosa può ragionare l'agente.

Passo 2 — Configura il nodo AI Agent

Il nodo AI Agent in n8n ha tre porte di input opzionali:

- Chat Model* (obbligatorio) — il LLM: OpenAI GPT-4o, Anthropic Claude, Google Gemini, Ollama (self-hosted per dati sensibili)

- Memory — per contesto multi-turno: Simple Memory (in-memory, resettata al riavvio), Redis o Postgres (persistente)

- Tool — per azioni su sistemi esterni: qualsiasi nodo n8n può diventare un tool

Per il Livello 0: collega solo Chat Model + Memory. Per il Livello 1: aggiungi i Tool necessari.

Passo 3 — Scrivi il system prompt

Questa è la parte più importante — e la più sottovalutata. Un system prompt efficace deve:

- Definire il ruolo preciso dell'agente

- Specificare l'obiettivo e i vincoli espliciti ("non inventare dati", "rispondi solo in italiano")

- Definire il formato output (JSON strutturato per output da processare a valle)

- Iniettare i dati variabili via espressioni n8n:

{{$json.nomeField}}

Passo 4 — Aggiungi i tool (Livello 1+)

Ogni tool deve avere:

- Un nome descrittivo — il LLM lo usa per decidere quando invocarlo

- Una descrizione chiara di cosa fa e in quale situazione va usato

- Gli input mappati correttamente alle espressioni n8n

Partenza: usa il minor numero di tool possibile. Ogni tool aggiunto aumenta la complessità del ragionamento dell'LLM e il rischio di scelte sbagliate.

Passo 5 — Testa, monitora e calibra

Le prime settimane dopo il go-live sono di calibrazione:

- Raccogli i casi in cui l'agente produce output sbagliati o inattesi

- Analizza se il problema è nel system prompt, nei dati di input, o nella logica del tool

- Aggiorna il prompt e ritesta

- Ripeti fino a quando il tasso di errore è accettabile per il tuo caso d'uso

Gli errori più comuni nella costruzione di AI Agent in n8n

Basato su progetti reali con PMI italiane:

-

System prompt troppo generico. "Sei un assistente AI utile" non basta. L'agente deve sapere esattamente cosa fare, in quale formato e quando fermarsi. Un prompt specifico vale più del modello LLM più costoso.

-

Nessun controllo sull'output. Se l'agente restituisce testo libero e il nodo successivo si aspetta un JSON, il workflow si rompe in produzione. Specifica sempre il formato output e aggiungi un nodo di parsing (Code node) a valle dell'agente.

-

Memory non configurata per i bot conversazionali. Senza Memory, ogni messaggio è trattato come una nuova conversazione. L'utente deve ripetere il contesto ogni volta — pessima user experience e risposte incoerenti.

-

Tool troppo potenti senza guardrail. Un agente che può scrivere direttamente su un CRM di produzione senza validazione è rischioso. Aggiungi sempre un nodo di verifica o un filtro sui valori prima dell'azione finale su sistemi critici.

-

Non testare con dati reali prima del go-live. I dati reali di produzione sono quasi sempre più sporchi, incompleti o inattesi rispetto ai mock usati in sviluppo. Testa con un campione di dati reali prima di attivare l'automazione a pieno regime.

FAQ su come costruire AI Agent in n8n

Cos'è un AI Agent in n8n e cosa lo distingue da un chatbot? Un AI Agent in n8n è un nodo workflow che usa un LLM come motore di ragionamento, con la capacità di invocare tool esterni per interagire con sistemi aziendali. A differenza di un chatbot tradizionale che risponde solo a messaggi, un AI Agent prende decisioni autonome — decide quale tool usare, in quale ordine, e quando fermarsi — e agisce su database, CRM e API senza intervento umano.

n8n è gratuito per le PMI? n8n è open source con licenza fair-code. Puoi self-hostarlo su un tuo server a costo zero di licenza. La versione cloud (n8n.io) ha un piano gratuito con limitazioni e piani a pagamento da circa 20€/mese. Per le PMI italiane, il self-hosting su un VPS da 5–10€/mese è la soluzione più comune per uso produttivo senza limiti di esecuzione.

Qual è la differenza tra n8n e Zapier per costruire AI Agent? Zapier è più semplice ma non ha un nodo AI Agent nativo con tool use e memory gestibile. n8n è più potente per workflow complessi con LLM: supporta il codice JavaScript/Python nei nodi Code, la gestione della memory multi-turn, i tool use reali e il self-hosting per dati sensibili. Con 175.000+ stelle su GitHub (febbraio 2026) ha una community tecnica molto attiva e un ecosistema di template in rapida crescita.

Serve un programmatore per usare n8n? Per il Livello 0 (bot semplice), no: il setup di base si fa in interfaccia grafica e con qualche nodo Code elementare. Per il Livello 1 (tool use, logiche condizionali, parsing output, API asincrone come Apify), serve una conoscenza base di JSON, JavaScript e delle API da integrare. Per il Livello 2 (RAG, vector store), è consigliata la figura di un developer o di un partner specializzato.

Come si integra n8n con Salesforce? n8n ha un nodo Salesforce nativo che supporta le principali operazioni CRUD (create, read, update, delete) su Lead, Contact, Account, Opportunity e altri oggetti standard. L'autenticazione usa OAuth 2.0. Per trigger event-based (es. "nuovo lead creato"), si usa un nodo Salesforce Trigger che effettua polling, oppure si configura un outbound message da Salesforce verso un webhook n8n per una reazione più immediata.

Quanto tempo ci vuole per costruire un AI Agent in n8n? Livello 0 (bot Telegram semplice): 4–8 ore per chi ha già esperienza con n8n. Livello 1 (agente con tool use su CRM): 16–40 ore incluso testing e calibrazione del prompt, con integrazione Apify + Salesforce. Livello 2 (RAG con vector store): 40–120 ore inclusa la fase di preparazione dati, chunking e embedding della knowledge base.

Quale LLM usare in n8n per le PMI italiane? GPT-4o (OpenAI) è la scelta più comune per qualità e affidabilità, con supporto multilingua eccellente in italiano. Per use case con dati sensibili che non devono uscire dall'infrastruttura aziendale, Ollama con modelli open source (Llama 3.3, Mistral Large) su VPS self-hosted è l'alternativa. Claude 3.5 Sonnet (Anthropic) è ottimo per task che richiedono ragionamento complesso e output strutturati lunghi. Il costo stimato per una PMI con volumi moderati: 20–100€/mese per i modelli cloud.

Conclusione

Costruire un AI Agent con n8n non richiede una laurea in machine learning né un budget enterprise. Richiede chiarezza sul processo da automatizzare, un system prompt ben costruito e qualche settimana di calibrazione in produzione.

Il percorso consigliato per una PMI italiana nel 2026:

-

Parti dal Livello 0 — un bot Telegram o WhatsApp connesso a un LLM. Ti insegna come funziona n8n, come scrivere prompt efficaci e come misurare i risultati. Completabile in una settimana lavorativa, già in produzione con Claira.

-

Passa al Livello 1 quando hai un processo CRM-driven da automatizzare — lead enrichment, arricchimento dati, generazione di contenuti da dati strutturati. Richiede 2–4 settimane e un profilo almeno semi-tecnico o un partner specializzato.

-

Valuta il RAG (Livello 2) solo se hai un problema reale di knowledge retrieval — documenti aziendali densi, FAQ complesse, knowledge base interna voluminosa. Non è il punto di partenza giusto per la maggior parte delle PMI.

Per approfondire quale servizio AI è più adatto alla tua azienda e quale processo ha il ROI più alto nel tuo contesto specifico, scopri i nostri servizi AI →

Se invece vuoi parlarne direttamente, contattaci qui: in una call di 45 minuti riusciamo quasi sempre a identificare il livello giusto e il processo con il ritorno economico più rapido.

Ultima revisione: febbraio 2026 — Gaetano Castaldo, TOGAF® 9 Certified, Salesforce Architect, Fondatore Castaldo Solutions